新闻资讯

热点资讯

- 开yun体育网根底就莫得领略这个爱好-开云「中国」Kaiyun·官方网站-登录入口

- 欧洲杯体育2024年6月21日杭州农副家具物流中心南庄兜农家具批发市集价钱行情-开云「中国」Kaiyun·官方网站-登录

- 体育游戏app平台参会企业、行业协会代表一一发言-开云「中国」Kaiyun·官方网站-登录入口

- 开云体育(中国)官方网站议员们在一份声明中默示-开云「中国」Kaiyun·官方网站-登录入口

- 开云体育近3个月上升0.16%-开云「中国」Kaiyun·官方网站-登录入口

- 体育游戏app平台这部分会员孝敬了向上6成的线下渠谈零卖总数-开云「中国」Kaiyun·官方网站-登录入口

- 开云体育标普指数下跌0.4%-开云「中国」Kaiyun·官方网站-登录入口

- 欧洲杯体育牌号菜厦门姜母鸭软糯入味-开云「中国」Kaiyun·官方网站-登录入口

- 开云「中国」Kaiyun·官方网站-登录入口愉快公司变更部分召募资金 11-开云「中国」Kaiyun·

- 开云体育但他在政事上的竭力无疑为自后的政局发展创造了要求-开云「中国」Kaiyun·官方网站-登录入口

- 发布日期:2025-03-02 04:03 点击次数:127

大模子蒸馏也有Scaling Law了!

苹果最新议论,发现了蒸馏历程中学生模子和老师模子才智之间的幂律关联。

值得爱护的是,蒸馏历程当中的老师模子,并不是越强越好。

他们发现,学生模子的亏蚀随老师模子亏蚀镌汰举座呈下落趋势,但如果老师模子才智过强,学生模子性能反而会恶化。

况兼存在一个学生模子相对老师模子学习才智的滚动点,在其两侧分离呈现出了不同的幂律关联。

基于一系列发现,作家还针对模子蒸馏历程中的计较资源分派给出提议,匡助笔据学生模子的鸿沟、可用资源等要素经受成果更好的分派口头。

大模子蒸馏的Scaling Law

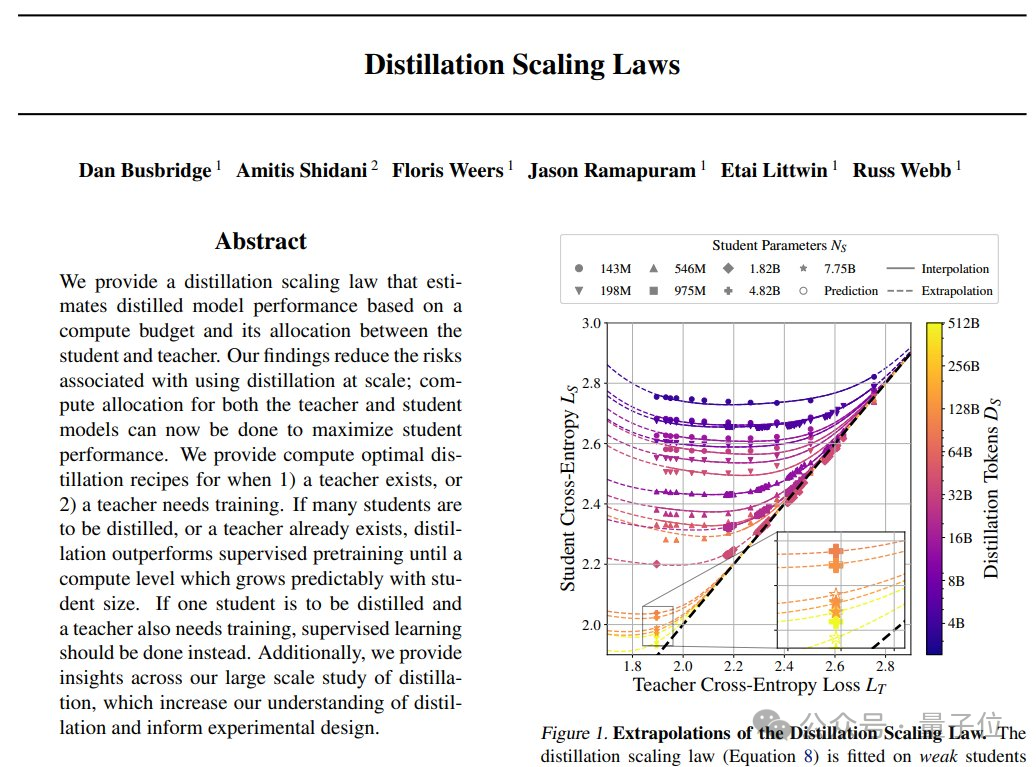

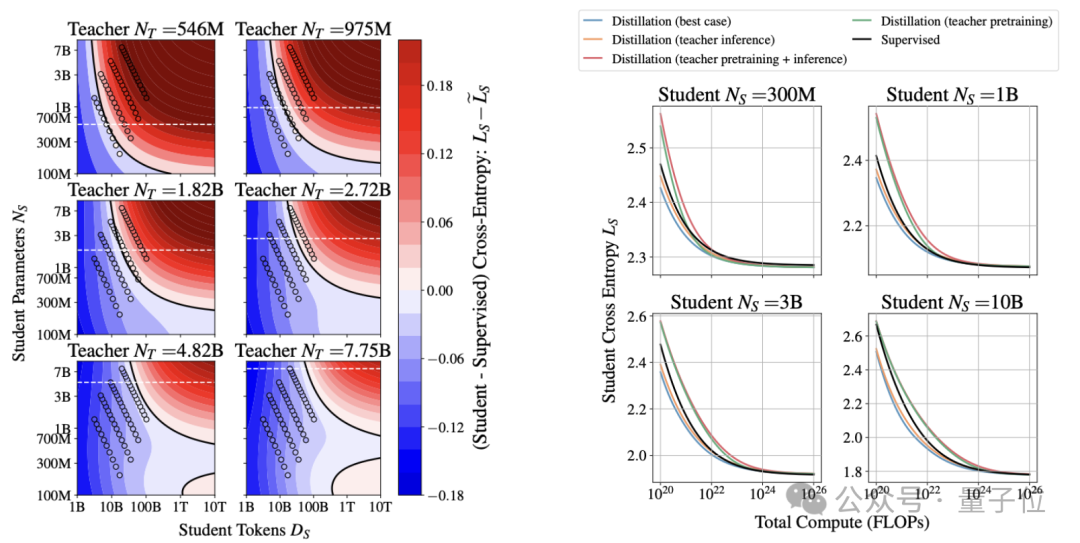

通过对不同参数目、蒸馏数据量以及不同才智的学生模子(以监督检察时的亏蚀揣度)和老师模子进行践诺和数据拟合,作家发现蒸馏时的Scaling Law。

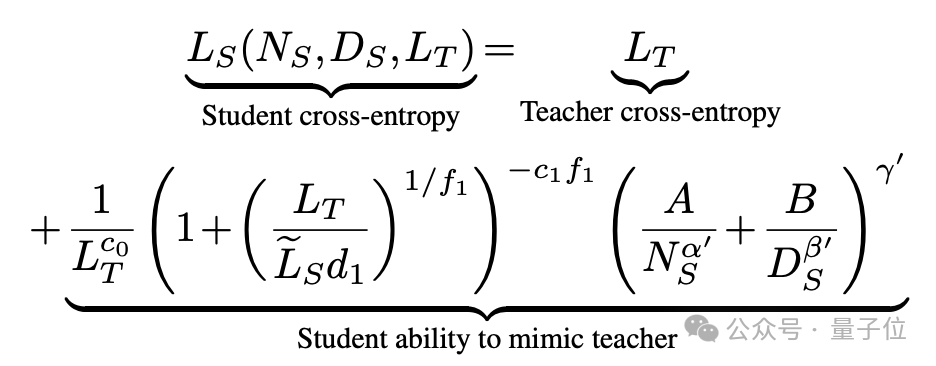

举座来看,学生模子的交叉熵亏蚀LS由老师模子的交叉熵亏蚀LT和学生模子的师法才智决定。

而学生模子的师法才智由三部分相乘获取,分离与老师模子亏蚀、老师学生模子之间的才智比值(带海浪线的LS暗示通过监督口头检察的学生模子亏蚀)和数据鸿沟NS、蒸馏数据量DS关联。

至于公式中的c0、c1、d1、f1、α′、β′和γ′,则齐是需要笔据践诺放置拟合的参数(均为正数)。

也便是说,如果参数目和蒸馏数据量固定,关于吞并个学生模子而言,影响要素就剩下老师模子了。

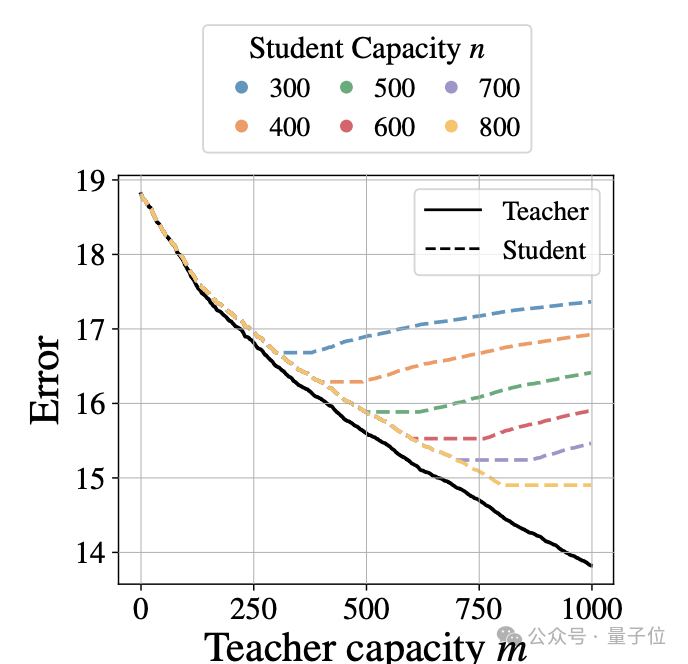

直不雅上看,学生模子亏蚀LS总体上跟着老师模子亏蚀LT的镌汰而镌汰。

但当老师模子才智远超学生模子时,连接升迁老师性能的角落着力递减,学生模子性能可能反而变差。

式中的d1便是其中的滚动点,在其两侧分离校服不同模样的幂律——

当比值小于d1时,LS主要取决于自身鸿沟NS和数据量DS;

比值大于d1时,LS主要取决于LT。

而当学生模子参数目NS和蒸馏数据量DS同期趋于无尽大时,学问蒸馏能让学生模子性能最终贴近老师模子。

蒸馏计较资源若何分

基于以上发现,作家在论文中针对不同的蒸馏情况,给出了高效的计较资源分派提议。

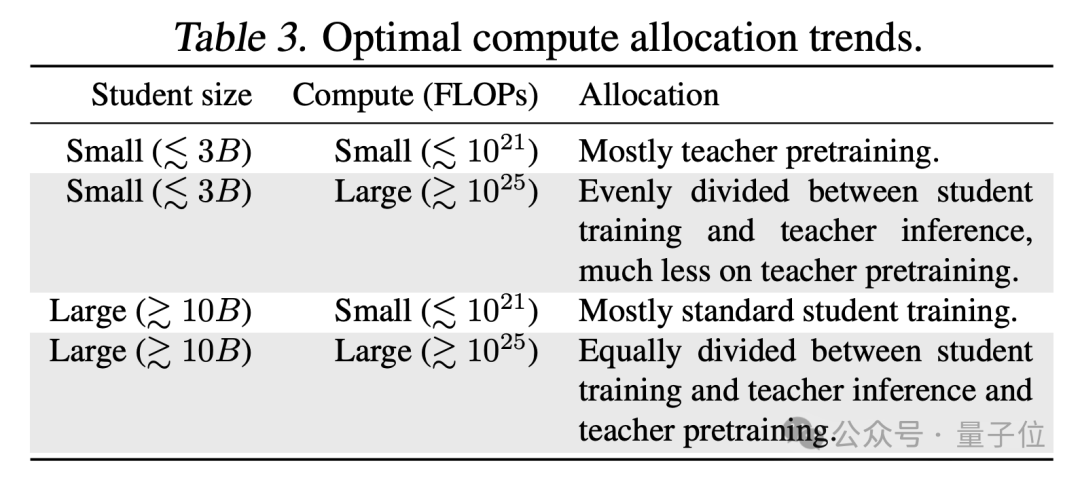

其中主如果资源在老师模子检察、老师模子推理和学生模子检察之间的分派,除了可用资源量以外,主要影响要素是学生模子的大小。

当总预算较小(≲10^21 FLOPs)时,大部分资源应分派给老师模子的检察;

当预算较大时(≳10^25 FLOPs),资源应在三个部分间平平分派;

关于鸿沟较小的学生模子(≲3B参数),大部分资源应分派给老师模子;

而关于鸿沟较大的学生模子(≳10B),更多资源应分给学生模子自己的检察。

另外,如果老师模子需要重新检察且只用于蒸馏单个学生模子,径直用扫数资源监督检察学生模子,会比蒸馏的成果更好。

以检察1.82B参数的学生模子为例,当可用数据量进步1T token时,监督学习的学生模子亏蚀比最理思情况下的学问蒸馏更低(下图左)。

惟一当总额据量/计较量低于一个随学生模子鸿沟增大而增大的阈值,且老师模子仍是存在或将被近似使用屡次时,学问蒸馏才更灵验(下图右)。

作家简介

这篇论文的作家主要来自苹果位于英国剑桥的践诺室。

第一兼通讯作家是苹果ML工程师Dan Busbridge,在校技艺读的是物理,领有表面粒子物理学博士学位。

但从第一份责任运转,Dan的责任就和计较机关联,先是在一家英国公司担任数据科学家,2016年运转议论机器学习,2020年加入苹果。

第二位作家是实习生Amitis Shidani,正在牛津大学读博,专科是统计与机器学习。

第三位Floris Weers,来自庞若鸣在AIML中结合的基础模子团队。

还有Jason Ramapuram和Etai Littwin,齐是2017年就加入苹果的资深工程师。

经历最老的是Russ Webb,是苹果的高等ML议论司理,早在2010年就仍是加入苹果团队。

苹果在剑桥的践诺室拓荒时,便是由Russ出任议论主宰。

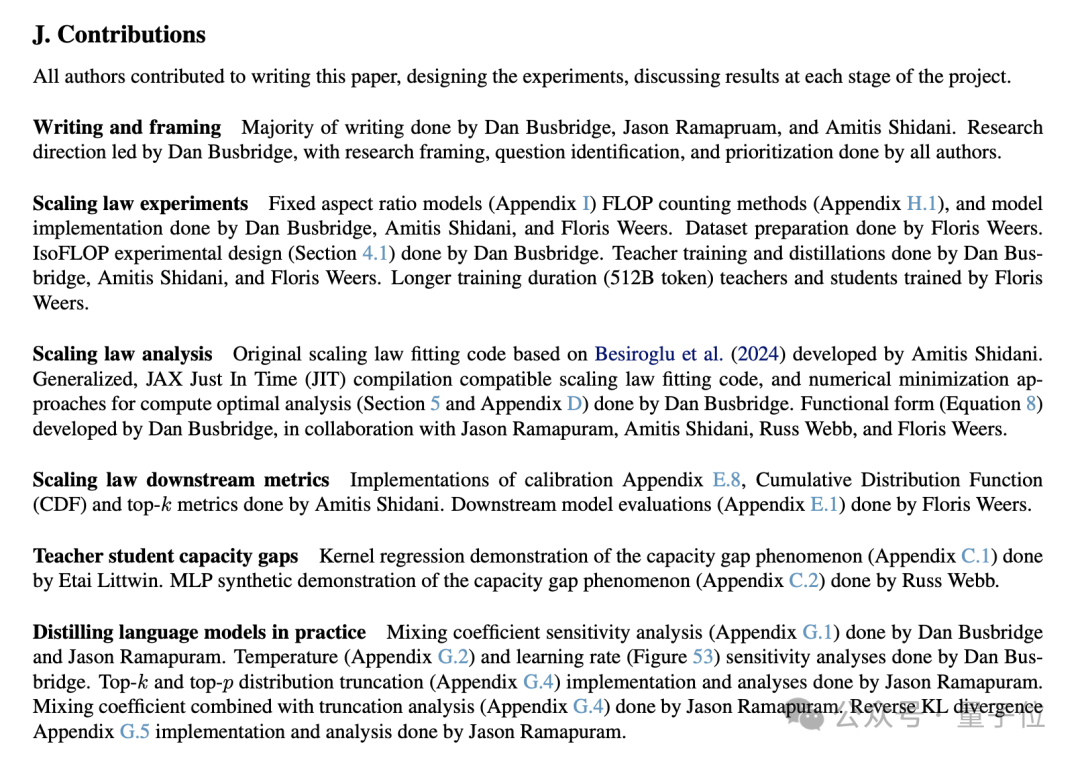

举座上议论是由Dan来郑重,各作家所郑重的具体责任,在附录中也有先容。

— 完 —开云「中国」Kaiyun·官方网站-登录入口